LM Studio: Execute LLAMA3 e Explore Novos Modelos no seu PC

LM Studio surge como uma ferramenta revolucionária para quem busca explorar o vasto mundo da inteligência artificial diretamente do conforto de seu próprio computador. Com uma interface acessível e recursos poderosos, este software é ideal tanto para estudantes quanto para entusiastas da área, permitindo não apenas o aprendizado, mas também a experimentação prática com diversos modelos de IA.

Recentemente, a Meta, proprietária do Facebook, Instagram e WhatsApp, lançou no dia 18 de abril de 2024 uma nova versão do seu modelo de inteligência artificial, o Llama3, marcando mais um avanço significativo no campo da IA. Este lançamento reflete o esforço contínuo das grandes empresas de tecnologia para desenvolver e aprimorar tecnologias que possam competir com produtos de gigantes como OpenAI e Google. O LM Studio permite testar esses modelos inovadores, incluindo o LLAMA3 da Meta, que é open source e estará entre os modelos que exploraremos de forma prática em nosso vídeo.

Imagine poder personalizar e configurar seu ambiente de desenvolvimento de IA como nunca antes, explorando desde funcionalidades básicas até as mais avançadas. O LM Studio não apenas facilita essas operações, mas também proporciona um suporte robusto através de uma comunidade ativa e engajada.

Ao longo deste artigo, abordaremos aspectos essenciais como o que é o LM Studio, suas principais características, especificações e requisitos necessários, como utilizá-lo efetivamente, detalhes sobre suas funcionalidades, dicas de personalização e configuração, e como aproveitar ao máximo o suporte oferecido pela comunidade.

Preparado para transformar sua maneira de interagir com a inteligência artificial? Vamos mergulhar no universo do LM Studio e descobrir como essa ferramenta pode ampliar suas habilidades e seu entendimento sobre IA, usando exemplos do dia a dia para facilitar o aprendizado e tornar a tecnologia mais acessível e aplicável em situações reais. Além disso, exploraremos de forma prática no nosso vídeo como usar o LLAMA3, garantindo que você possa aplicar imediatamente o que aprender.

Conteúdo

O que é LM Studio?

LM Studio é uma plataforma avançada destinada a facilitar o desenvolvimento e a exploração de modelos de inteligência artificial em computadores pessoais. A ferramenta é projetada para ser acessível a estudantes e profissionais da área de dados e inteligência artificial, proporcionando um ambiente rico em recursos que permite desde a criação até a execução de modelos de IA de maneira simplificada.

Confira o passo a passo para instalação do LM Studio:

- Acesse o site oficial do LM Studio.

- Na página inicial, escolha a versão do software adequada para seu sistema operacional (Mac, Windows, ou Linux) e faça o download.

- Inicie a instalação do arquivo baixado e aguarde a finalização do processo.

Estes passos garantirão que você instale a versão mais recente do LM Studio em seu computador, permitindo que você comece a explorar e a desenvolver com inteligência artificial de forma eficiente e segura.

Principais Funcionalidades do LM Studio

LM Studio é equipado com uma série de funcionalidades projetadas para maximizar a eficiência e a acessibilidade no desenvolvimento de inteligência artificial. Aqui estão algumas das principais funcionalidades que destacam este software no mercado:

- Execução de LLMs no Laptop Sem Conexão com a Internet: O LM Studio permite que você execute modelos de linguagem de grande escala (LLMs) diretamente no seu laptop, sem necessidade de conexão com a internet, proporcionando maior privacidade e controle sobre seus projetos de IA.

- Uso de Modelos por Meio da Interface de Chat ou Servidor Local: Você pode interagir com modelos de IA através de uma interface de chat intuitiva fornecida pela aplicação ou configurar um servidor local que é compatível com as APIs da OpenAI, facilitando a integração e o uso em diversos contextos.

- Download de Arquivos de Modelos Compatíveis: A plataforma permite o download de arquivos de modelos diretamente dos repositórios do Hugging Face, garantindo acesso a uma vasta gama de modelos pré-treinados que podem ser utilizados para diversos fins educativos e profissionais.

- Descoberta de Novos e Notáveis LLMs: Na página inicial da aplicação, os usuários podem descobrir novos e notáveis modelos de linguagem de grande escala (LLMs), mantendo-se atualizados com as últimas tendências e avanços no campo da inteligência artificial.

Estas funcionalidades destacam o LM Studio como uma ferramenta versátil e poderosa para quem deseja explorar e desenvolver projetos de IA, seja em ambiente acadêmico, de pesquisa ou no desenvolvimento profissional.

Especificações e Requisitos

Para garantir uma experiência fluida e eficiente ao usar o LM Studio, é essencial dispor de um hardware adequado que possa suportar as demandas dos modelos de inteligência artificial. A seguir, detalhamos os requisitos mínimos de hardware e software necessários para o uso efetivo da plataforma:

O que é RAM?

RAM (Random Access Memory ou Memória de Acesso Aleatório) é um tipo de memória de computador que é utilizada para armazenar dados e códigos de programas em execução. RAM é essencial para processar informações rapidamente, o que é crucial ao trabalhar com modelos de IA que exigem grandes quantidades de dados simultaneamente.

O que é AVX2?

AVX2 (Advanced Vector Extensions 2) refere-se a uma extensão das instruções x86 para microprocessadores, que melhora o desempenho em operações de ponto flutuante, muito usadas em cálculos de inteligência artificial, garantindo que o processamento seja mais rápido e eficiente.

O que é VRAM?

VRAM (Video RAM) é a memória utilizada exclusivamente pela placa de vídeo do computador. Ela é crucial para processar gráficos e vídeos, mas também é muito importante em aplicações de IA, especialmente aquelas que envolvem processamento visual ou gráfico intenso.

Aqui estão os requisitos recomendados para diferentes sistemas operacionais:

| Sistema Operacional | Processador | RAM Recomendada | VRAM Recomendada |

|---|---|---|---|

| Macs | M1/M2/M3 | 16GB+ | N/A |

| Windows/Linux | Suporte para AVX2 | 16GB+ | 6GB+ |

Você pode utilizar o Z-ZPU, disponível em https://www.cpuid.com/softwares/cpu-z.html, para verificar facilmente todas as informações de compatibilidade do seu sistema. Isso pode facilitar significativamente o processo de configuração inicial, assegurando que o LM Studio possa operar de maneira otimizada, permitindo que estudantes e profissionais da área de dados e inteligência artificial explorem ao máximo as capacidades do software sem interrupções ou limitações técnicas.

Parâmetros de Inferência no LM Studio:

Os parâmetros de inferência são fundamentais para controlar a forma como os Modelos de Linguagem de Grande Escala (LLMs) geram respostas, impactando diretamente a qualidade, relevância e eficiência dessas respostas. O ajuste desses parâmetros permite uma personalização profunda do comportamento dos modelos, adequando-os às necessidades específicas de cada aplicação.

Importância dos Ajustes nos Parâmetros

Para usuários avançados, compreender e ajustar esses parâmetros oferece uma maneira poderosa de otimizar o desempenho dos modelos. Isso não só melhora a qualidade das respostas geradas, mas também garante que o processamento seja feito de maneira eficiente, respeitando as limitações de recursos do sistema.

Benefícios dos Ajustes

- Qualidade das Respostas: Ajustar parâmetros como

top_ketop_pajuda a refinar as respostas, tornando-as mais precisas e contextuais. - Eficiência no Processamento: Configurações como

n_predicten_threadspermitem balancear a carga de processamento, melhorando a velocidade de resposta sem comprometer a profundidade da análise realizada pelo modelo. - Redução de Repetições: O parâmetro

repeat_penaltyé crucial para evitar repetições indesejadas, melhorando a naturalidade e a fluidez do texto gerado.

Ao ajustar esses parâmetros, os usuários podem tirar o máximo proveito dos LLMs no LM Studio, adaptando os modelos para atender de forma ótima às demandas de diferentes tipos de tarefas de processamento de linguagem natural.

Navegando pelas Funcionalidades do LM Studio

Explorar o LM Studio é mergulhar em um universo de possibilidades para a manipulação e interação com modelos de linguagem de última geração. Para uso básico, basta baixar um modelo inicial e começar a utilizar a aba de chat. No entanto, para quem tem curiosidade em explorar mais profundamente, separamos os pontos mais importantes de cada uma das seis abas principais que compõem a interface do usuário, cada uma projetada para facilitar e enriquecer sua experiência com inteligência artificial.

Home

- Dicas de Uso: Comece com modelos LLM menores e progrida para modelos maiores conforme as capacidades do seu hardware.

- Resumo de Modelos: Informações e destaques sobre alguns modelos disponíveis para experimentação.

Search

- Pesquisa Detalhada de Modelos: Permite a pesquisa por modelos utilizando filtros avançados, palavras-chave ou diretamente pela URL do Hugging Face.

- Informações de Sistema: Exibe informações disponíveis sobre a GPU e RAM da máquina.

- Integração com Hugging Face: Possibilidade de clicar em um modelo e abrir diretamente sua página no site do Hugging Face para mais detalhes e download.

Chat

A aba ‘Chat’ é o coração do LM Studio, onde a maior parte da interação com os Modelos de Linguagem de Grande Escala (LLMs) acontece. Essa aba é projetada para ser intuitiva e flexível, permitindo aos usuários tanto a execução de conversas imediatas com modelos pré-carregados quanto a personalização detalhada das interações através de configurações avançadas. É aqui que você pode realmente experimentar o poder da inteligência artificial ao conversar diretamente com os modelos, fazendo desta aba a mais utilizada e vital para a exploração prática dos LLMs.

- Seleção e Carregamento de Modelos: Você pode selecionar um modelo e carregar as configurações necessárias para iniciar uma sessão de chat.

- Presets de Configuração: Utilize presets pré-fabricados para casos de uso específicos ou crie e importe seus próprios presets de configuração.

- Parâmetros de Inferência:

- Temp (temperatura): Controla a aleatoriedade das respostas do modelo. Um valor mais alto resulta em respostas mais variadas e menos previsíveis.

- N_predict (número de previsões): Define quantas previsões o modelo deve fazer antes de escolher a mais provável. Um número maior pode melhorar a qualidade da resposta, mas aumenta o tempo de processamento.

- Top_k: Limita o número de possíveis próximas palavras a considerar durante a geração de texto. O modelo considerará apenas as k palavras mais prováveis, onde k é o valor deste parâmetro.

- Repeat_penalty (penalidade de repetição): Penaliza palavras que já apareceram, reduzindo a probabilidade de serem escolhidas novamente. Isso ajuda a evitar repetições no texto gerado.

- Min_p (probabilidade mínima): Estabelece um limiar mínimo de probabilidade para que uma palavra seja considerada pelo modelo. Palavras com probabilidade abaixo desse limiar serão descartadas.

- Top_p (probabilidade cumulativa): Semelhante ao top_k, mas em vez de limitar o número de palavras, limita a soma cumulativa de suas probabilidades. O modelo só considera as palavras mais prováveis até que a soma de suas probabilidades alcance o valor definido por top_p.

- N_threads (número de threads): Determina quantos threads de processamento serão usados para realizar a inferência. Aumentar o número de threads pode acelerar o processo de geração de texto, mas também aumenta o uso de recursos do sistema.

Playground

- Sessões Multi-modelo: Permite usar vários LLMs simultaneamente.

- Configurações Personalizadas: Ajuste individual para cada modelo.

- Guardrails: Prevenção de sobrecarga do sistema.

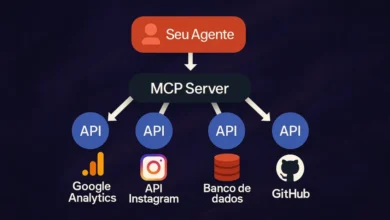

Local Server

- Servidor HTTP Local: Simula endpoints da API da OpenAI, permitindo testes e integrações locais.

- Documentação da API: Acesso facilitado à documentação online para uso eficiente do servidor.

My Models

- Gerenciamento de Modelos: Visualize e gerencie os modelos baixados.

- Sugestões de Modelos: Recomendações de modelos populares para download.

- Visualização do Tamanho: Informações sobre o tamanho dos arquivos dos modelos.

Comunidade e Suporte

O LM Studio está firmemente apoiado por uma vibrante comunidade open source dedicada ao avanço da inteligência artificial. Esta comunidade não apenas contribui para o desenvolvimento contínuo da plataforma, mas também oferece suporte robusto aos usuários através de diversos canais. Abaixo, você encontrará informações sobre os principais repositórios e canais de comunicação onde você pode se engajar, aprender e obter suporte.

| Plataforma | URL | Descrição |

|---|---|---|

| GitHub | lmstudio-ai | Repositório oficial com código fonte e contribuições da comunidade. |

| LMStudioAI | Siga para atualizações, dicas e comunicação direta com a equipe e comunidade. | |

| Discord | LM Studio Discord | Junte-se ao servidor para discussões, suporte em tempo real e colaboração com outros usuários. |

| Documentação | LM Studio Docs | Acesse a documentação completa para uma compreensão profunda de todas as funcionalidades e dicas de uso. |

Através destes canais, você pode colaborar em projetos, resolver dúvidas e compartilhar suas experiências com outros entusiastas e profissionais da área. A comunidade LM Studio está sempre pronta para ajudar e expandir o conhecimento em inteligência artificial, tornando-a mais acessível a todos.

Como usar o LLAMA3 local em seu PC

A Meta lançou em 18 de abril de 2024 a mais recente adição à sua linha de modelos de inteligência artificial generativa de código aberto: o Llama 3. Este lançamento marca um avanço significativo em termos de capacidades de IA, com o Llama 3 prometendo desempenho superior em relação a modelos concorrentes.

O Llama 3 está disponível em duas versões: o Llama 3 8B, que contém 8 bilhões de parâmetros, e o Llama 3 70B, com 70 bilhões de parâmetros. Estes modelos foram treinados em clusters de 24.000 GPUs personalizadas, posicionando-os entre os modelos de IA generativa de melhor desempenho atualmente disponíveis.

As avaliações de desempenho realizadas por avaliadores humanos ressaltam particularmente o desempenho robusto do modelo Llama 3 70B. Este modelo mostrou-se notavelmente competente na execução de instruções em cenários do mundo real, estabelecendo um novo padrão de excelência no campo dos Modelos de Linguagem de Grande Escala (LLMs). Veja os detalhes dessa liderança de mercado na tabela de avaliação de modelos a seguir:

| Teste / Modelo | Meta Llama 3 8B | Mistral 7B | Gemma 7B | Meta Llama 3 70B | Gemini Pro 1.0 | Mixtral 8x22B |

|---|---|---|---|---|---|---|

| MMLU 5-shot | 66.6 | 62.5 | 63.9 | 79.5 | 71.8 | 77.7 |

| AGIEval Inglês 3-5-shot | 45.9 | — | 44.0 | 63.0 | — | 61.2 |

| BIG-Bench Difícil 3-shot, CoT | 61.1 | — | 56.0 | 81.3 | 75.0 | 79.2 |

| Desafio ARC 25-shot | 78.6 | 78.1 | 78.7 | 93.0 | — | 90.7 |

| DROP 3-shot, F1 | 58.4 | 54.4 | — | 79.7 | 74.1 | 77.6 |

Para aqueles entusiasmados com dados e que desejam analisar a fundo o desempenho soberbo dos modelos LLAMA 3 em comparação com outros grandes modelos de IA, recomendamos a consulta do benchmark oficial fornecido pela Meta. Este relatório detalhado oferece uma visão aprofundada das capacidades e do impacto dos modelos LLAMA 3 em uma variedade de tarefas de inteligência artificial. Você pode acessar este benchmark e explorar todos os detalhes técnicos no seguinte link: Meta LLAMA 3 Benchmark.

Para utilizar o LM Studio e empregar o LLAMA3 de forma prática e fácil, sem a necessidade de conhecimento avançado de programação, acompanhe nosso guia completo no YouTube. Este vídeo oferece um passo a passo prático e insights valiosos para que você possa aproveitar ao máximo o potencial do seu modelo de IA.

Assista ao vídeo detalhado abaixo para explorar todo o potencial deste avançado modelo de inteligência artificial diretamente do conforto de sua casa ou escritório, de maneira simples e acessível.

Conclusão

Esperamos que este guia tenha fornecido uma visão abrangente e prática sobre o uso do LM Studio e a integração do modelo LLAMA3 em seu ambiente de trabalho local. Com as ferramentas e conhecimentos apresentados, você está agora melhor equipado para explorar o campo da inteligência artificial, aplicando as funcionalidades avançadas do LM Studio em projetos reais e experimentos de aprendizado.

Para complementar sua jornada de aprendizado, convidamos você a explorar nosso guia detalhado sobre a plataforma Hugging Face. Acesse Explorando a Plataforma Hugging Face para aprofundar ainda mais seus conhecimentos sobre essa ferramenta influente no campo da inteligência artificial.

Lembre-se de que a comunidade e os recursos online estão disponíveis para ajudar a expandir sua experiência e resolver quaisquer dúvidas. Continue explorando e inovando com o LM Studio, uma ferramenta poderosa que abre portas para o futuro da tecnologia de inteligência artificial.